전통적인 머신러닝 모델: SVM, Decision Tree, Random Forest, Gradient Boosting

오늘은 머신러닝에서 전통적이고 기본이 되는 네 가지 주요 알고리즘을 개념적으로 살펴볼 거예요.

SVM(Support Vector Machine), Decision Tree, Random Forest, Gradient Boosting은 각각 독특한 특징과 강력한 예측 성능을 가진 알고리즘으로, 머신러닝의 기초를 이루는 중요한 모델들입니다.

1. SVM (Support Vector Machine)

1.1. 개념

SVM은 주어진 데이터에서 두 클래스를 가장 잘 구분하는 경계(Decision Boundary)를 찾는 데 초점이 있어요.

이 경계를 Hyperplane이라고 부르며, 데이터를 분리하는 선 또는 면을 의미합니다. SVM의 핵심은 이 Hyperplane과 데이터를 구분하는 마진을 최대한으로 넓히는 것입니다.

마진을 넓힌다는 것은 초평면 근처의 데이터 포인트들과 거리를 최대화하는 것을 의미해요. 이렇게 하면 새로운 데이터가 주어졌을 때 일반화(generalization) 능력이 좋아져 더 정확한 예측을 할 수 있게 됩니다.

이 과정에서 중요한 역할을 하는 것이 바로 Support Vector인데요, 이는 Hyperplane에 가장 가까이 위치한 데이터 포인트들로, Hyperplane의 위치와 방향을 결정짓는 데 사용돼요. Support Vector가 왜 중요할까요? Hyperplane을 정의할 때 모든 데이터가 아니라, 이 중요한 몇 개의 데이터만 참고하기 때문이에요.

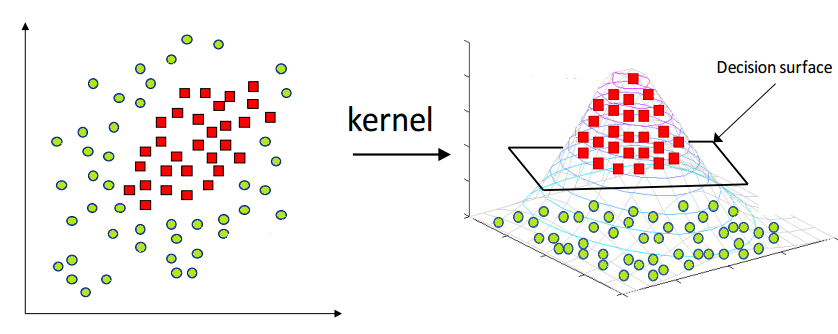

비선형 데이터는 어떻게 처리할까?

Kernel Trick(커널 기법)을 사용하여 데이터를 더 높은 차원으로 변환해 비선형 데이터를 선형적으로 구분할 수 있게 합니다. 예를 들어, 이차원에서 원형으로 얽힌 데이터를 삼차원으로 매핑하면 직선으로 쉽게 구분할 수 있게 되는 원리입니다. 자주 사용하는 커널에는 Linear, Polynomial, RBF(Radial Basis Function) 등이 있어요.

1.2. 특징

고차원 데이터에 강함

SVM은 데이터의 Feature(특징) 수가 많을수록 강력한 성능을 발휘해요. 예를 들어, 텍스트 분류 문제에서 수천 개의 단어 Feature도 효과적으로 처리할 수 있습니다.

적은 데이터 샘플에서도 효과적

데이터가 제한적이거나 샘플 수가 적은 경우에도 우수한 성능을 보여줍니다. 예를 들어, 의료 데이터처럼 데이터 수집이 어려운 환경에서도 유용하게 활용됩니다.

뛰어난 일반화 성능

SVM은 Hyperplane과 데이터 사이의 여백(Margin)을 최대로 확보하는 구조 덕분에, 새로운 데이터에 대한 예측 정확도가 매우 높습니다.

커널 기법으로 비선형 문제 해결 가능

선형적으로 나뉘지 않는 데이터를 처리하기 위해 SVM은 커널 기법을 사용해 데이터를 고차원으로 변환합니다. 주요 커널로는 RBF(Radial Basis Function), Polynomial, Linear 등이 있으며, 이를 통해 다양한 데이터 형태를 유연하게 다룰 수 있어요.

이진 분류 문제에서 강력한 성능

스팸 메일 분류, 이미지 내 객체 유무 판별과 같은 이진 분류 문제에서 특히 뛰어난 성능을 발휘합니다.

단점: 대규모 데이터에서 속도 저하

SVM은 데이터 샘플 수가 많거나 Feature가 지나치게 많아질 경우 연산 비용이 급격히 증가해 학습 속도가 느려질 수 있습니다.

하이퍼파라미터 튜닝이 중요

SVM의 성능은 C(여백에 대한 패널티)와 커널 유형 같은 하이퍼파라미터 설정에 큰 영향을 받습니다. 적절한 하이퍼파라미터 튜닝이 필요하지만, 이는 시간이 많이 소요될 수 있습니다.

SVM은 고차원 데이터와 제한된 데이터 환경에서 특히 유용하며, 다양한 분류 문제에서 강력한 성능을 발휘합니다. 하지만 대규모 데이터에서는 속도와 연산 비용 문제를 고려해야 합니다. 😊

2. Decision Tree

2.1. 개념

Decision Tree는 트리(tree) 구조를 활용해 의사 결정을 수행하는 지도 학습 알고리즘이에요. 이 알고리즘은 데이터를 여러 단계로 분할하며 최종적으로 예측값을 제공합니다. 각 분기점(Node)은 특정 질문을 기반으로 데이터를 분리하고, 리프 노드(Leaf Node)에서 최종 결과를 제공합니다.

작동 방식을 살펴보면, Decision Tree는 데이터의 특징(feature)을 기준으로 가장 "유용한" 특징을 선택해 데이터를 나누는데요, 이때 유용성을 판단하는 기준으로 Gini Impurity(지니 불순도) 또는 Entropy(엔트로피) 같은 값을 사용해요.

- 첫 번째 질문: "고객의 나이는 30대 이상인가요?"

- 두 번째 질문: "구매 금액은 10만 원 이상인가요?"

- 마지막 질문: "최근 구매 이력이 있나요?"

이런 방식으로 질문을 반복하면서 데이터를 좁혀 나갑니다.

중요 개념

- Gini Impurity와 Entropy

- Gini Impurity는 데이터가 얼마나 혼합되어 있는지를 측정하며, 낮을수록 한쪽 클래스가 우세하다는 것을 의미해요.

- Entropy는 데이터의 불확실성을 측정하며, Decision Tree는 엔트로피를 최소화하도록 학습합니다.

- Tree Depth(트리 깊이)

- 트리의 깊이가 너무 깊으면 모델이 데이터를 지나치게 세밀하게 학습해 과적합(overfitting)이 발생할 수 있어요. 반대로 트리가 너무 얕으면 데이터의 패턴을 충분히 학습하지 못해 성능이 떨어질 수 있죠.

- 적절한 트리 깊이는 데이터셋 크기와 복잡성에 따라 결정돼요.

2.2. 특징

데이터의 구조를 빠르게 분석 가능

Decision Tree는 직관적인 트리 구조 덕분에 데이터를 빠르게 이해하고 분석할 수 있어요. 시각화가 쉬워 데이터의 분할 기준과 결과를 명확히 파악할 수 있습니다.

분류(Classification)와 회귀(Regression) 모두에 활용 가능

분류 문제(예: 고객의 대출 승인 여부)와 회귀 문제(예: 주택 가격 예측) 모두에서 사용할 수 있는 유연한 알고리즘이에요.

결측값이나 전처리가 부족한 데이터에 유연

데이터가 결측값을 포함하거나, 스케일링과 같은 전처리가 충분히 이루어지지 않은 경우에도 잘 작동합니다. 이런 점에서 복잡한 전처리가 어려운 초기 데이터 분석 단계에 특히 유용해요.

해석 가능성이 높음

Decision Tree는 작동 과정을 시각적으로 이해하기 쉬워요. 예를 들어, "고객의 신용 점수가 700 이상이면 대출을 승인한다"는 식으로 명확하게 설명할 수 있습니다.

빠르고 효율적인 학습

단일 Decision Tree는 학습과 예측 속도가 빠르기 때문에, 작은 데이터셋에서 효율적으로 사용할 수 있어요.

과적합 가능성

트리가 너무 깊어질 경우, 훈련 데이터에 지나치게 적합해 새로운 데이터에 대한 성능이 저하될 수 있습니다. 이를 방지하기 위해 최대 깊이 제한, 최소 샘플 분할 개수 등의 하이퍼파라미터를 조정해야 합니다.

Feature 중요도 계산 가능

Decision Tree는 데이터를 분할하는 과정에서 특정 Feature(특징)가 얼마나 중요한지를 가중치로 계산해줍니다. 이 정보를 통해 Feature Selection(특징 선택)을 효율적으로 수행할 수 있어요.

3. Random Forest

3.1. 개념

Random Forest는 여러 개의 Decision Tree를 조합하여 예측 성능을 향상시키는 Ensemble Learning 기법이에요. 단일 Decision Tree가 가진 단점을 보완하고자 설계된 알고리즘으로, 여러 Decision Tree를 개별적으로 학습시키고, 이들의 예측 결과를 합산(분류 문제는 다수결, 회귀 문제는 평균)해 최종 예측을 만듭니다.

Random Forest는 이름에서도 알 수 있듯이 Randomness가 핵심이에요.

- 각 Tree는 서로 다른 데이터 샘플(학습 데이터를 무작위로 샘플링한 Subset)로 학습됩니다. 이를 Bagging(Bootstrap Aggregating)이라고 불러요.

- 각 Tree는 데이터를 나눌 때 모든 Feature를 고려하지 않고, 무작위로 선택된 일부 Feature만 사용합니다. 이를 Feature Randomness라고 해요.

이 두 가지 무작위성을 통해 Decision Tree들이 서로 독립적으로 학습할 수 있도록 만들어지고, 각 Tree의 결과를 결합하면 overfitting을 방지하면서도 높은 정확도를 얻을 수 있어요. 예를 들어, 만약 한 트리가 데이터를 잘못 분류했다면, 다른 트리들은 해당 실수를 보완하는 방식으로 작동하기 때문에 전체 모델의 예측 성능이 향상됩니다.

3.2. 특징

잡음이 많거나 복잡한 데이터에서 강력한 성능

Random Forest는 데이터셋에 노이즈(잡음)가 많거나 구조가 복잡한 경우에도 안정적인 결과를 제공합니다. 여러 Decision Tree의 예측 결과를 결합(앙상블)하기 때문에 단일 모델보다 더 정확하고 신뢰도 높은 결과를 얻을 수 있어요.

결측값이 있는 데이터 처리 가능

데이터에 결측값이 포함되거나 일부 값이 손실된 경우에도 Random Forest는 유연하게 작동합니다. 전처리가 부족한 데이터에서도 비교적 높은 성능을 보이는 점이 큰 장점이에요.

Feature가 많은 데이터셋에 적합

Random Forest는 각 Decision Tree를 학습할 때 무작위로 선택된 Feature만 사용하는 방식을 적용합니다. 이로 인해 Feature 수가 많아도 과적합(overfitting)을 방지하면서 효율적으로 학습할 수 있어요.

분류(Classification)와 회귀(Regression) 문제 모두에서 활용 가능

Random Forest는 범주를 예측하는 분류 문제(예: 질병 유무 판별)와 연속값을 예측하는 회귀 문제(예: 주택 가격 예측) 모두에서 뛰어난 성능을 발휘합니다. 이로 인해 다양한 머신러닝 문제에 폭넓게 활용할 수 있는 알고리즘이에요.

높은 정확도와 안정성

Random Forest는 단일 Decision Tree보다 예측 성능이 더 뛰어나며, 여러 Tree의 예측을 평균화하거나 다수결로 결합해 안정성을 높입니다. 특히 데이터가 복잡하거나 노이즈가 많을수록 이 강점이 두드러져요.

과적합 방지에 효과적

각 Tree가 서로 다른 데이터 샘플과 Feature로 학습하기 때문에, 개별 Tree가 데이터를 과도하게 학습하는 것을 방지합니다. 이로 인해 Random Forest는 과적합의 위험이 낮고, 일반화(generalization) 성능이 뛰어납니다.

해석 가능성이 낮음

Random Forest는 여러 Tree의 예측 결과를 결합하는 방식으로 작동하므로, 단일 Decision Tree에 비해 모델이 내린 결정 과정을 해석하기가 어렵습니다. 모델의 복잡성 때문에 "어떤 Feature가 어떤 기준으로 결과에 영향을 미쳤는지"를 명확히 설명하기 어렵다는 한계가 있어요.

다만, Random Forest는 많은 Tree를 학습시키기 때문에 연산 비용이 비교적 높아질 수 있어요. 학습 속도가 느려질 수 있으므로 대규모 데이터셋에서는 GPU 등의 하드웨어를 활용하는 것이 필요할 수 있습니다.

4. Gradient Boosting

4.1. 개념

Gradient Boosting은 Weak Learner를 순차적으로 학습시켜 예측 성능을 점진적으로 개선하는 강력한 Ensemble Learning 기법이에요. Gradient Boosting의 핵심은 이전 학습 모델이 만든 오차(Residual Error)를 학습하는 새로운 모델을 추가하면서, 반복적으로 전체 모델의 예측 성능을 높이는 것입니다. Decision Tree가 약한 학습기로 사용되는 경우가 많으며, 이를 점진적으로 개선해나가는 방식이죠.

Gradient Boosting의 이름에서 알 수 있듯이, 이 알고리즘은 Gradient Descent을 활용해 학습 과정에서 Loss를 최소화하려고 합니다.

- Loss Function은 모델의 예측값과 실제값 간의 차이를 측정하는 기준이에요.

- Gradient Descent는 손실 함수를 최소화하기 위해 기울기를 따라 모델을 점진적으로 업데이트하는 최적화 방법입니다.

이 과정에서 각각의 약한 학습기는 이전 모델의 오류를 보완하려고 학습하며, 이 과정이 반복될수록 점점 더 강력한 예측 모델을 만들어냅니다. 예를 들어, 첫 번째 Tree가 잘못 분류한 데이터에 더 많은 가중치를 부여해 두 번째 Tree가 이를 학습하게 하고, 이후 모델이 계속해서 보완 작업을 진행하는 방식이에요.

4.2. 특징

복잡한 데이터셋 처리

Gradient Boosting은 데이터의 패턴이 복잡하고 Feature 간 상호작용이 중요한 경우 탁월한 예측 성능을 보여줍니다. 예를 들어, 금융 데이터나 의료 데이터처럼 변수가 많고 상호작용이 중요한 문제에서 효과적이에요.

높은 정확도가 요구되는 문제

Gradient Boosting은 많은 머신러닝 대회(Kaggle, DrivenData 등)에서 우승 모델로 자주 사용됩니다. 대회용 모델링에서는 거의 기본 옵션으로 사용될 만큼 높은 예측 정확도를 자랑해요.

소규모 데이터셋에서도 강력한 성능

Gradient Boosting은 적은 양의 데이터로도 강력한 성능을 발휘할 수 있어요. 데이터가 제한적인 환경에서도 높은 성능을 유지할 수 있는 점이 큰 장점이에요.

높은 예측 성능

Gradient Boosting은 약한 학습기(Weak Learner)들을 순차적으로 결합하면서 학습하기 때문에 매우 높은 성능을 보여줍니다.

이 과정에서 데이터의 복잡한 패턴을 효과적으로 포착할 수 있어요.

분류(Classification)와 회귀(Regression) 문제 모두에서 활용 가능

분류 문제(예: 질병 여부 예측)와 회귀 문제(예: 주택 가격 예측) 모두에서 활용되며, 다양한 머신러닝 문제에 적용할 수 있는 유연성을 가지고 있습니다.

과적합 위험

Gradient Boosting은 매우 강력한 모델이지만, 학습 과정에서 데이터에 과도하게 적합(overfitting)될 가능성이 있어요. 이를 방지하기 위해 트리의 깊이, 학습률(Learning Rate), 부스팅 단계 수와 같은 하이퍼파라미터를 신중히 조정해야 합니다.

학습 속도가 느림

Gradient Boosting은 순차적으로 학습하는 구조이기 때문에 Random Forest에 비해 학습 속도가 느린 편이에요. 하지만 XGBoost, LightGBM, CatBoost와 같은 구현체를 활용하면 속도와 성능을 동시에 향상시킬 수 있습니다.

5. 각 알고리즘의 선택 기준

머신러닝 알고리즘을 선택할 때는 데이터의 특성과 목표에 따라 가장 적합한 모델을 선택하는 것이 중요해요. 네 가지 알고리즘(SVM, Decision Tree, Random Forest, Gradient Boosting)은 각기 다른 강점과 특성을 가지고 있어서 상황에 맞게 활용할 수 있어요. 아래는 주요 선택 기준입니다.

SVM (Support Vector Machine)은 고차원 데이터와 샘플 크기가 적은 상황에서 적합한 알고리즘이에요. 고차원 데이터를 효과적으로 처리하며, 커널 기법을 통해 비선형 문제도 해결할 수 있는 유연성을 가지고 있습니다. 특히 텍스트 분류나 이미지 분류와 같은 이진 분류 문제에서 강력한 성능을 발휘합니다. 하지만 데이터 샘플이 많거나 Feature 수가 지나치게 많아지면 학습 속도가 느려지고, 하이퍼파라미터(C와 커널 유형) 튜닝에 민감하다는 점은 한계로 작용할 수 있어요.

Decision Tree는 단순하고 해석 가능한 모델이 필요한 경우에 적합합니다. 트리 구조 덕분에 데이터를 빠르게 분석하고, 시각화하여 직관적으로 이해할 수 있는 점이 큰 장점이에요. 분류와 회귀 문제 모두에서 활용 가능하며, 데이터 전처리가 부족하거나 결측값이 포함된 데이터에서도 잘 작동합니다. 그러나 단독으로 사용할 경우 트리가 너무 깊어질 수 있어 과적합 위험이 있고, 성능이 제한적이라는 점을 염두에 두어야 합니다.

Random Forest는 안정적이고 정확한 결과를 원할 때 선택하기 좋은 알고리즘이에요. 여러 Decision Tree를 결합해 노이즈와 복잡한 데이터에 강하며, 과적합을 방지하면서도 높은 정확도를 제공합니다. 또한 결측값이 있거나 Feature가 많은 데이터에서도 잘 작동합니다. 다만, 여러 Tree를 조합하는 과정에서 학습 속도가 느리고, 모델이 내린 결정을 해석하기 어렵다는 단점이 있어요.

Gradient Boosting은 데이터가 복잡하거나 대규모 데이터셋에서 최고의 성능이 필요할 때 선택하기 적합합니다. 약한 학습기들을 순차적으로 학습하여 높은 예측 성능을 제공하며, 데이터의 복잡한 패턴을 잘 포착하는 강점을 가지고 있어요. 특히 머신러닝 대회(Kaggle 등)에서 자주 사용되는 모델로, 분류와 회귀 문제 모두에서 탁월한 성능을 발휘합니다. 하지만 학습 속도가 느리고, 과적합의 위험이 있으므로 적절한 하이퍼파라미터 튜닝이 필수적입니다.

💡 팁: 어떤 알고리즘을 조합해야 할까요?

실무에서는 한 가지 알고리즘만 사용하는 것보다는 여러 알고리즘을 조합하거나 Ensemble 기법을 활용하는 경우가 많아요:

- Random Forest와 Gradient Boosting: 일반적으로 가장 안정적이고 정확한 결과를 제공하므로, 복잡한 문제에 자주 사용돼요.

- SVM과 Decision Tree의 조합: 데이터를 이해하는 초기 단계에서는 Decision Tree로 빠르게 인사이트를 얻고, 최적의 성능을 목표로 SVM이나 다른 모델을 시도하는 방식으로 활용할 수 있어요.

- 하이브리드 방식: 데이터의 특성에 따라, 분류 문제에 SVM을 사용하고, 회귀 문제에 Gradient Boosting을 사용하는 식으로 알고리즘을 혼합해 사용할 수도 있어요.

최근엔 LLM, Foundation Model 등의 기술이 주목받고 있지만, SVM, Decision Tree, Random Forest, Gradient Boosting과 같은 전통적인 머신러닝 알고리즘은 여전히 실무에서 중요한 역할을 하고 있어요. 특히, 이 알고리즘들은 데이터의 크기와 복잡성, 문제의 특성에 따라 강력한 성능을 발휘하며, 실용적인 문제 해결의 기반이 됩니다.

또한, 이 알고리즘들은 현대 머신러닝 응용 기법의 핵심 아이디어를 이해하는 데도 중요한 출발점이에요. 예를 들어, Gradient Boosting은 LightGBM, XGBoost, CatBoost와 같은 고속화된 라이브러리로 발전했고, Random Forest는 랜덤성(randomness)을 활용한 다양한 Ensemble 기법의 기반이 되었죠.

결국, 머신러닝에서 중요한 것은 최신 기술만 사용하는 것이 아니라, 문제를 제대로 이해하고 그에 적합한 도구를 선택하는 능력이에요. 전통적인 알고리즘과 현대적인 기법을 함께 활용하면 실무에서 더 강력한 솔루션을 만들 수 있을 거예요😊