Word2Vec

Word2Vec은 자연어 처리 및 텍스트 분석 분야에서 사용되는 중요한 워드 임베딩 기술이다. 워드 임베딩은 단어를 고차원 벡터로 표현하는 기술로, 이러한 벡터는 단어 간의 의미적 유사성을 캡처하고 수학적 연산을 통해 단어 간의 관계를 분석하는 데 사용된다.

이미지의 경우 컴퓨터에 저장되는 형태 자체가 0~255의 RGB 값으로 저장되기에 이 값을 그대로 CNN, Transformer 등의 딥러닝 아키텍처에 입력으로 넣을 수 있지만, 단어의 경우 임베딩하는 과정이 별도로 필요하다.

Word2Vec은 단어 임베딩을 학습하기 위한 방법 중 하나로, 두 가지 주요 아키텍처인 CBOW(Continuous Bag of Words)와 Skip-gram을 사용하는데, 이 두 가지 모델은 다음과 같이 동작한다.

Continuous Bag of Words (CBOW)

CBOW 모델은 문맥 내 주변 단어들을 통해 타깃 단어를 예측한다. 예를 들어, "I am learning ___"라는 문장에서 빈칸에 들어갈 단어를 예측하는 것이다. 주변 단어의 임베딩 벡터를 평균하여 타깃 단어의 임베딩 벡터를 얻는다.

Skip-gram

Skip-gram 모델은 타깃 단어를 가지고 주변 단어를 예측한다. 즉, "learning"을 가지고 "I", "am" 등의 주변 단어를 예측하는 것이다.

타깃 단어를 중심에 두고 주변 단어의 임베딩 벡터를 학습한다.

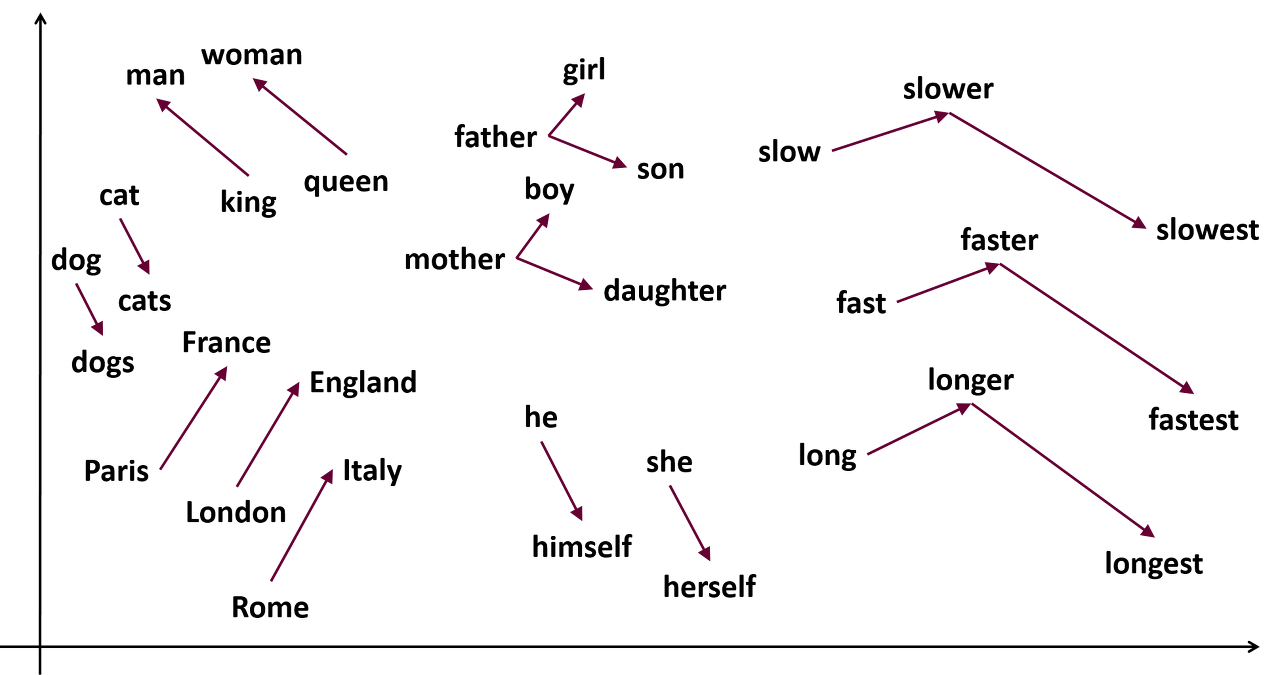

Word2Vec 모델은 대량의 텍스트 데이터를 학습하여 단어 간의 의미적 유사성을 캡처하며, 결과적으로 유사한 의미를 가진 단어들은 비슷한 임베딩 공간에 매핑된다. 이러한 임베딩은 다양한 자연어 처리 작업에 사용될 수 있으며, 예를 들어 문서 분류, 단어 간 관계 추론, 검색 엔진, 기계 번역, 감정 분석 등의 작업에서 유용하게 활용된다.

Word2Vec은 단어 임베딩을 효율적으로 학습하고 단어 간 의미적 관계를 포착하는 데 매우 효과적인 방법 중 하나이며, 자연어 처리 분야에서 널리 사용되고 있다

Word2Vec 활용

Word2Vec는 단어 임베딩을 생성하는 데 사용되며, 문서 분류, 자동 요약, 검색, 추천 시스템, 기계 번역, 감정 분석 등 다양한 자연어 처리 작업에서 활용된다.

하지만, 최근 BERT나 GPT 같은 언어 모델들은 텍스트를 임베딩하기 위해 토큰화(tokenization) 과정을 거친다. 토큰화는 텍스트를 작은 단위로 나누는 프로세스로, 일반적으로 단어, 서브워드 또는 문자 수준으로 텍스트를 분할한다. 이러한 토큰은 모델의 입력으로 사용되며, 각 토큰은 해당 텍스트 조각의 의미적 표현을 나타내는 벡터로 변환된다.

관련 레포지토리

- word2vec 레포 (1.5k stars) : https://github.com/dav/word2vec

- 한국어 word2vec인 kor2vec (약 200 stars) : https://github.com/naver/kor2vec

- 30+ 언어 word2vec (2.2 stars) : https://github.com/Kyubyong/wordvectors

'📖 Theory > NLP' 카테고리의 다른 글

| [NLP] TF-IDF 설명 | 텍스트 데이터 통계적 가중치 계산 | 특정 단어가 문서 내에서 얼마나 중요한지 (0) | 2023.09.22 |

|---|