반응형

오늘은 딥러닝에서 핵심적인 최적화 알고리즘인 Gradient Descent (경사 하강법) 에 대해 알아보려고 해요. 이 알고리즘이 딥러닝 모델을 학습하고 최적화하는 데 어떻게 활용되는지 함께 살펴보겠습니다.

경사 하강법의 개념

Gradient Descent는 함수의 기울기(Gradient)를 이용하여 함수의 최솟값을 찾아가는 최적화 알고리즘입니다. 딥러닝에서는 손실 함수(Loss Function)의 값을 최소화하기 위해 많이 사용됩니다.

동작 원리

- 기본 개념:

- 경사 하강법은 초기에 임의의 파라미터에서 시작하여, 각 단계에서 손실 함수의 그래디언트를 계산하고, 그래디언트의 반대 방향으로 파라미터를 조정하여 최적화를 수행합니다.

- 주요 단계:

- 초기화(Initialization): 파라미터(가중치와 편향)를 임의의 값으로 초기화합니다.

- 순전파(Forward Propagation): 입력 데이터를 네트워크에 주입하고 예측값을 계산합니다.

- 오차 계산(Error Calculation): 예측값과 실제값 사이의 오차를 계산합니다.

- 역전파(Backward Propagation): 오차를 역방향으로 전파하여 각 파라미터에 대한 그래디언트를 계산합니다.

- 파라미터 업데이트(Parameter Update): 계산된 그래디언트를 사용하여 파라미터를 조정합니다. 이 과정을 반복하여 손실 함수의 값을 최소화하려고 합니다.

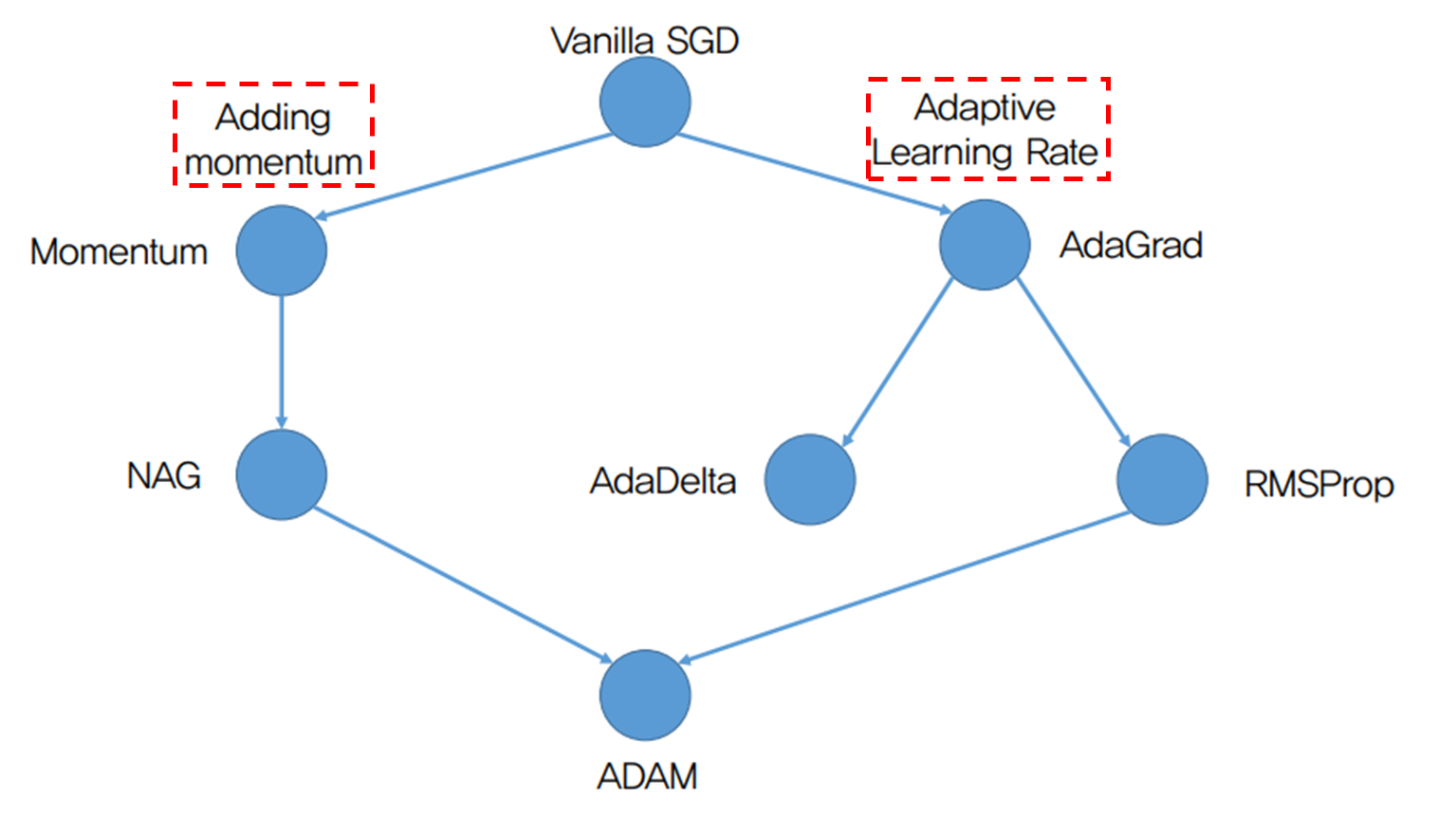

경사 하강법의 종류

- SGD(Stochastic Gradient Descent)

- Batch Gradient Descent : 전체 Dataset에 대해 parameter 들의 gradient를 구함(많은 memory 필요)

- SGD : 전체 dataset에서 mini-batch 만큼의 gradient를 계산하여 parameter update

- Batch gradient descent 보다 빠르지만 local minima를 잘 빠져나가지는 못함

- Momentum

- SGD+Momentum : momentum 성분을 추가하여 local minima를 탈출할 수 있음

- 단점 : Global minima에서 멈추지 못하고 넘어가 버릴 수 있음

- NAG(Nesterov Accelerated Gradient)

- Momentum step을 밟고 이동한 위치에서 gradient 계산하여 이동 -> minima에 안정적으로 도달 가능

- 단점 : 모든 Parameter들의 step size가 동일(최적화에 가까워진 값도 있고 먼 값도 있을 테니까)

- Adagrad(Adaptive Gradient)

- Gt 는 gradient 값을 받아 얼마나 변해왔는지를 알 수 있고, Gt-1 값을 추가하여 이전 값을 추가

- 얼마나 변해왔는지에 대한 값을 반비례시켜 곱하므로 각 parameter값이 변한 정도에 따라 Learning rate를 조절

- 단점 : Gt의 값이 계속 더해져 가므로 발산할 수 있음 -> Step size가 매우 작아짐

- RMSProp

- Gt에 γ 값을 추가해서 발산하지 않도록 조절 -> step size 작아지는 것 방지

- Adam(Adaptive Momentum Estimation)

- NAG와 RMSprop의 장점을 합침

- β_1=0.9,β_2=0.999 일 때, (1-β_1 )=0.1,(1-β_2 )=0.001 이 되어, m>>v -> 첫 step 너무 커짐

경사 하강법의 중요성

- 모델 최적화: 딥러닝 모델을 학습하고 최적화하는 데 필수적인 알고리즘입니다.

- 하이퍼파라미터 튜닝: 학습률(Learning Rate)과 같은 하이퍼파라미터를 조정하여 학습 속도와 최적화 성능을 개선할 수 있습니다.

오늘은 Gradient Descent의 개념과 종류에 대해 알아보았습니다. 딥러닝에서 이 알고리즘이 어떻게 작동하는지 이해하는 것은 모델을 개발하고 최적화하는 데 있어서 필수적입니다.

반응형

'📖 Fundamentals > AI & ML' 카테고리의 다른 글

| [ML] 전통적인 머신러닝 모델: SVM, Decision Tree, Random Forest, Gradient Boosting (0) | 2024.12.09 |

|---|---|

| [AI/ML] Matrix Factorization(행렬 분해)와 머신러닝 (0) | 2024.12.09 |

| [AI/ML] 딥러닝 핵심 개념: Back Propagation (오차 역전파)의 이해와 응용 (0) | 2024.07.11 |

| [AI/ML] 머신러닝 : 지도학습, 비지도학습, 강화학습 이해하기 (0) | 2024.07.11 |

| [AI/ML] 머신러닝의 정의와 기본 개념 (0) | 2024.07.11 |